Jak rozumieć pliki RAW? Czym się charakteryzują i jak je ugryźć? Czy RAW jest strawny, czy nie za bardzo? Czy bezkarnie można używać nazwy RAW? Dlaczego? I… czy w ogóle nam się przyda? Znacie odpowiedzi? To nie czytajcie! Nie znacie? W takim przypadku zapraszamy do mięsistej lektury.

Poniższy tekst jest skrótem tekstu, który ukazał się na łamach FilmPRO. Publikujemy go z drobnymi zmianami zostawiając esencję. Od chwili pojawienia się tekstu, tematyka, o której piszemy, nie straciła nic ze swojej aktualności.

Tekst: Krszysztof Włodarczyk

1. Wprowadzenie

Mimo ponad dziesięciu lat pracy z surowymi plikami z kamery, za każdym razem, gdy widzę nazwę RAW, wyobrażam sobie soczysty, krwisty stek. Sezonowane mięso nie poddane żadnej obróbce, z którego zależnie od potrzeb przygotuję sobie wymarzone danie. Czy je usmażę na patelni Rec. 709, czy zgrilluję na ruszcie DCI-P3, czy wsadzę na parę godzin do piekarnika ACES, zależy od tego, na co w danej chwili mam ochotę.

Nie wiem, czy autor nazwy „RAW” miał podobne skojarzenia, ale surowość pliku podkreśla, że nie został on poddany obróbce. W teorii plik RAW powinien być dokładnym zapisem z matrycy kamery. Bez żadnej ingerencji, tak żeby proces przetwarzania można było przeprowadzić z jak największą dokładnością, wykorzystując pełne możliwości zapisanego pliku.

Ten proces może kojarzyć się także z wywołaniem negatywu. Do takiego skojarzenia nawiązują nazwy niektórych formatów cyfrowego zapisu bezpośrednio z matrycy – Digital Negative [Cinema DNG = Cinema Digital NeGative; X-OCN = eXtended tonal range Original Camera Negative – przyp. red.]. Czyli podobnie jak w przypadku negatywu, w momencie wywoływania można podjąć decyzję, jakim procesom poddać plik i otrzymać gotowy obraz. Z jedną różnicą – plik RAW (czy Digital Negative, jak kto woli) można wywoływać w dowolnym momencie i na różne sposoby.

Surowy zapis w teorii powinien być wierną kopią informacji odczytanych bezpośrednio z przetwornika. Czy tak jest w rzeczywistości?

Nie do końca. Mimo że część formatów jest reklamowana jako nieskompresowany RAW, taki format w czystej formie nie istnieje. Za chwilę wytłumaczę dlaczego.

fot. Luis Bernardo Cano / obróbka Przemysław Mądrzak

2. Kompresja video i RAW

Zanim jednak przejdziemy do samych RAW-ów, warto przyjrzeć się już obrobionemu sygnałowi wideo i plikom, których używamy na co dzień. W pracy z materiałami wideo mamy do czynienia ze „zwykłymi” plikami RGB o określonej rozdzielczości, próbkowaniu koloru i kompresji. Każdy kodek, np. Apple Prores, jest formatem skompresowanym. Potocznie kodek, a właściwie koder-dekoder to algorytm odpowiedzialny za zakodowanie w trakcie zapisu i dekodowanie w trakcie odtwarzania. Zazwyczaj jego głównym celem jest zachowanie jak najlepszej jakości materiału przy jak najmniejszej objętości pliku. W większości przypadków kompresja kojarzy się z materiałami kiepskiej jakości, z blokową kompresją, streamingową, internetową itp. Ale nie zawsze tak musi być, bo kompresję możemy podzielić na stratną i bezstratną.

Kompresja stratna jest stosowana, gdy trzeba znacznie zredukować wielkość pliku wideo. Stosuje różnego rodzaju algorytmy, które decydują, jakie partie obrazu można pominąć albo uprościć w procesie kompresji tak, żeby zmiany były jak najmniej widoczne. Zmiany te będą jednak nieodwracalne, więc obróbka takiego materiału będzie już bardzo ograniczona. W momencie modyfikacji obrazu mogą się pojawić artefakty, które algorytm w formie nieobrobionej próbował ukryć dla naszej percepcji. Kompresję stratną stosuje się najczęściej do materiałów, które nie będą podlegały znacznej obróbce, do materiałów poglądowych albo finalnego formatu przeznaczonego do odbioru. Materiały skompresowane wymagają zazwyczaj dużej mocy obliczeniowej procesora w komputerze, na którym są dekodowane.

W przypadku kompresji bezstratnej zapis obrazu oryginalnego zostanie tak przetworzony w procesie kodowania, żeby w momencie odczytu wszystkie jego parametry idealnie zgadzały się z oryginałem. W tym przypadku jednak nie można znacznie ograniczyć wielkości pliku, zazwyczaj najwyżej o połowę, maksymalnie dwuipółkrotnie. Taki rodzaj kompresji może być niekiedy nazywany zakodowaniem (encoding), dla uniknięcia skojarzenia z kompresją stratną.

Podczas pracy przy większości projektów filmowych można korzystać ze standardowych skompresowanych obrazów RGB. Obraz w większości przypadków nie wymaga drastycznej ingerencji, a magazynowanie większej ilości materiału nie generuje gigantycznych kosztów.

Ale dlaczego nie pracujemy na plikach nieskompresowanych, skoro nośniki, na których zapisujemy, są coraz tańsze i mają coraz większe pojemności?

Otóż godzina nieskompresowanego materiału w HD z 10-bitowym próbkowaniem koloru podczas zapisu 25 kl/s zajmuje na dysku… 700 GB. Tyle samo miejsca zajmuje godzina nieskompresowanego 12-bitowego ARRIRAW 2,8K 16 x 9. Za to godzina materiału zarejestrowanego na kamerach RED, ale już w rozdzielczości 8K w skompresowanym 16-bitowym kodeku RECODE RAW 5:1 zajmuje zaledwie 900 GB. A to przecież 8 razy więcej danych, jak wynikałoby z samej rozdzielczości i 64 razy więcej, jeżeli chodzi o próbkowanie koloru na piksel! Ale gdybyśmy chcieli materiał z matrycy RED-a zapisać „bezkompresyjnie” w 8K i 16 bitach jako plik RGB, godzina materiału ważyłaby… 18 TB.

Jak to wszystko się mieści w plikach RAW?

fot. Luis Bernardo Cano / smarzył Przemysław Mądrzak

3. Liniowy zapis prosto z matrycy

Powoli zbliżamy się do rozłożenia RAW-ów na części pierwsze. Albo używając porównań kulinarnych, przyglądamy się bliżej marmurkowej strukturze naszego steka. I jego sezonowaniu przez różnych producentów.

Najpierw jednak prześledźmy, jak się odbywa zapis.

Przetwornik zamienia światło zogniskowane przez obiektyw na sygnał cyfrowy. Każdy piksel na przetworniku zapisuje tylko informację o natężeniu światła. Żeby zapisać informację o kolorze, przed przetwornikiem CMOS musi zostać umieszczony specjalny filtr, przepuszczający światło o różnej długości fal. Najczęściej jest to tzw. filtr Bayera, wyglądający jak trójkolorowa szachownica, gdzie na 2 pola zielone przypada po jednym polu niebieskim i czerwonym, każde dla oddzielnego piksela. Taki obraz przetworzony przez konwerter analogowo-cyfrowy może zostać zapisany jako surowy obraz RAW.

Zapis (nieobrobiony) bezpośrednio z matrycy nie jest jeszcze obrazem wideo. Zanim to nastąpi, musi zostać poddany wielu zabiegom albo w kamerze, albo w postprodukcji, m.in. wymaskowaniu martwych pikseli, usunięciu szumu cyfowego, ustaleniu poziomu czerni, demozaikowaniu do RGB (debayering), balansowi bieli itp. W teorii wszystkie te procesy powinny się odbywać w momencie przetwarzania pliku w postprodukcji. W praktyce jednak część z nich odbywa się już przed zapisem RAW, dlatego określenia marketingowe „nieprzetworzony RAW” nie są do końca prawdą.

Przy okazji warto zwrócić uwagę na jedną rzecz. Zapis RAW w teorii powinien odbywać się liniowo, bo światło padające na przetwornik daje wartości liniowe. Jeżeli na matrycę wpadnie dwa razy więcej światła, trzeba będzie zapisać 2 razy więcej danych. Zatem najwięcej danych zapisywane będzie w najjaśniejszych partiach obrazu, gdzie nasze oko już nie wychwytuje szczegółów. Dlatego do zapisu wprowadza się często gammy logarytmiczne, żeby informacje w światłach, których nasze oko by nie zauważyło, upakować w mniejszej ilości danych. Poza tym do niedawna trudno było wyświetlić na jakimkolwiek ekranie większą ilość szczegółów w jasnych partiach obrazu. Aż do teraz, gdy mamy ekrany HDR i w końcu w światłach widać więcej szczegółów. Dla osób pracujących w systemie ACES liniowy zapis RAW będzie miał dodatkowe znaczenie – system będzie korzystał z pełnej informacji odczytanej przez sensor, bez potrzeby konwersji zapisu logarytmicznego na liniowy.

Jakość tego zapisu zależy oczywiście od precyzji próbkowania. Większość producentów informuje, że odczyt z przetwornika odbywa się z 16-bitową precyzją. Ale zapis już niekoniecznie. A to dlatego, że nawet w przypadku liniowego 16-bitowego zapisu maksymalna rozpiętość tonalna kamery to byłoby właśnie 16 przysłon. Poza tym bardziej precyzyjne próbkowanie oznacza większe wielkości plików. Dlatego producenci używają albo „logarytmicznego 12-bitowego zapisu RAW”, albo tzw. „floating point”, żeby zmieścić jak największą ilość danych, ograniczając ich objętość. Nie jest to kompresja wynikająca z kodeka, tak jak wspominałem na początku, ale dodatkowy zabieg, powodujący zmniejszenie oryginalnego obrazu RAW.

Część procesów, które zachodzą w kamerze przed zapisem RAW, często poprawia jego jakość, maskując błędy pojawiające się przy odczycie, czyli między innymi martwe piksele. Podobnie z ustaleniem poziomu czerni czy usuwaniem szumów, co w przypadku niektórych przetworników zależne jest od czynników zewnętrznych, jak np. temperatura otoczenia.

Jak widać, nawet w wypadku kamer oferujących nieskompresowany, nieprzetworzony czy bezkompromisowy zapis RAW jakiś proces uproszczenia sygnału przed zarejestrowaniem jednak zachodzi. Jeżeli nie wpływa to na finalną jakość, to nie ma dużego znaczenia, ale warto sobie zdawać sprawę, że z „czystym” RAW-em nie mamy do czynienia.

4.Wywołanie RAWa

Możesz zaufać kucharzowi i poprosić o optymalne wg niego wysmażenie mięsa, które zamawiasz. Ale prawdziwy koneser będzie wiedział, czego potrzebuje. I jaki rodzaj mięsa najbardziej mu odpowiada: czy woli Rib Eye’a, czy może T-Bone’a…

Plik zapisany jako RAW nie nadaje się bezpośrednio do odtworzenia. Jak z każdym surowym mięsem – nawet tatara trzeba posiekać i doprawić.

Żeby zamienić surowy plik na RGB, potrzeba paru zabiegów. Przede wszystkim – demozaikowanie, znane powszechnie jako debayering – od nazwy filtra na sensorze [a właściwie od nazwiska naukowca, który to wymyślił: Bryce E. Bayer – przyp. red.]. Do tego momentu dla każdego piksela było zapisane nasycenie tylko jednego koloru, który został przepuszczony przez filtr (najczęściej Bayera) – zielonego, czerwonego lub niebieskiego. W procesie demozaikowania odzyskuje się informację o pozostałych kolorach dla każdego piksela, korzystając z wartości RGB sąsiadujących pikseli. Jest to skomplikowany proces, bo może powodować wiele błędów, dlatego występują różne algorytmy demozaikujące. Użytkownicy DaVinci Resolve na pewno kojarzą różne tryby debayeringu z pełnej rozdzielczości – albo fabryczne ustawienia producenta danej kamery, albo autorskie demozaikowanie Resolve. Te algorytmy są rozwijane wraz z rozwojem sprzętu i oprogramowania. Jeżeli dzisiaj spróbujemy otworzyć pierwsze pliki RAW z RED One, czy zarejestrowane na pierwszej Aleksie, ich jakość może być dużo lepsza. Ten proces zazwyczaj odbywa się przy wykorzystaniu procesorów graficznych w komputerze.

W ten sposób zostaje odtworzony sygnał z kamery w formie RGB, ale jeszcze bez narzuconych parametrów, dzięki którym można by go było obejrzeć na ekranie, takich jak balans bieli czy gamma. I to jest największy plus surowych plików: są idealną bazą do klasycznego stylu pracy na plikach logarytmicznych, ale można z nich też korzystać w systemie ACES bez potrzeby jakiejkolwiek transformacji. Możemy się delektować wszystkimi atutami RAW-a jak soczystym stekiem, biorąc nóż i widelec… przepraszam, panel do korekcji.

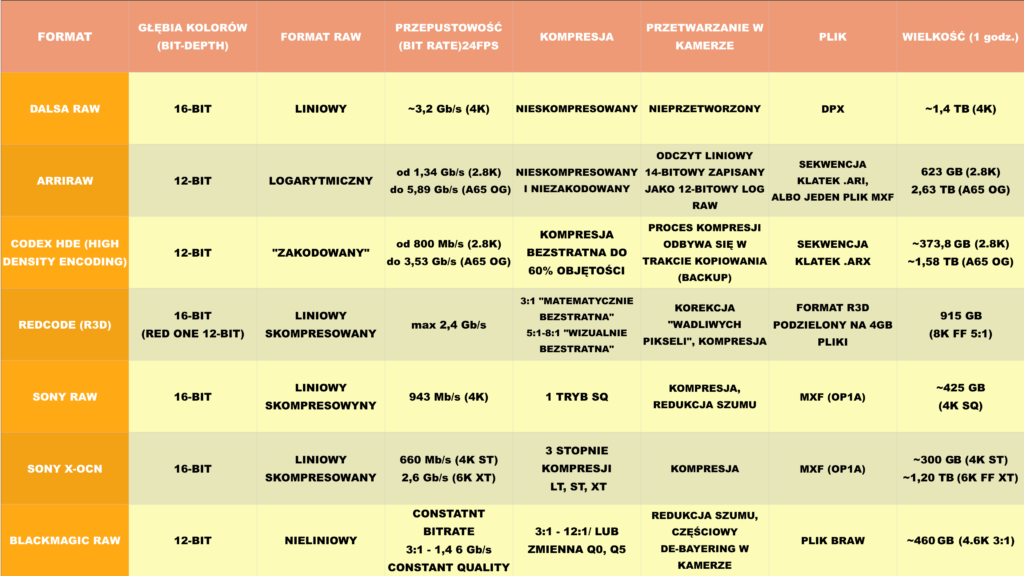

Tabela: Krzysztof Włodarczyk / Przemysław Mądrzak

5.Menu

Trochę zgłodniałem przy tych wywodach, czas więc sprawdzić, co mamy w menu lokalnego Steakhouse. Poza małym wstępem historycznym postaram się skupić na kamerach dostępnych w Polsce, bo jak wiadomo, jesteśmy jednym z największych koneserów plików RAW na świecie. Producenci odwiedzający nasz kraj przecierają oczy ze zdumienia, widząc, że nawet etiudy studenckie i reklamy majonezu kręcimy w ARRIRAW.

Rare – prawdziwy krwisty RAW

Jeżeli zapytamy obsługę o 16-bitowy nieskompresowany RAW w rozdzielczości 4K, odpowie, że już od dawna nie ma go w menu. Był, ale ponad dekadę temu. W latach 2003-2008 dostępny na kamerach Dalsa 4K Origin i Origin II. I tylko w restauracjach w Hollywood. Można go było zapisać na rekorderach Codeksa lub S-Two połączonych światłowodem Fibre Channel. Niestety Dalsa nie przyjęła się w Hollywood, mimo świetnych parametrów technicznych, lupy optycznej i dużej rozpiętości tonalnej. Była po prostu za droga. A pliki z niej, można rzec – zbyt tłuste (zapis z prędkością ~3,2 Gb/s). Do dzisiaj nie ma innej kamery, o której można by powiedzieć, że nagrywa w pełni nieskompresowany 16-bitowy RAW.

Medium rare – delikatnie wysmażony ARRIRAW

Niszę po Dalsie wypełniła firma ARRI ze swoimi pierwszymi kamerami cyfrowymi – ARRIFLEX D-20 i D-21 zapisującymi ARRIRAW (W Polsce jeszcze nie tak dawno można było wypożyczyć tę ostatnią w rentalu).

Wciąż krwisty, ale jednak trochę wysmażony (a kucharze twierdzą, że to najodpowiedniejszy sposób smażenia steków), ARRIRAW to format, który jest trochę inaczej przygotowany niż 16-bitowy RAW z Dalsy, bo zapisuje pliki nieskompresowane, ale 12-bitowe i już nie liniowo, a logarytmicznie. Format ten był przeznaczony dla najbardziej wymagających produkcji. Bo podobnie jak RAW Dalsy na tamte czasy był dosyć drogi. Na początku był reklamowany jako „nieprzetworzony 12-bitowy logarytmiczny surowy zapis danych z matrycy”, przechwytywany na rekordery podwójnym sygnałem HD-SDI – jako ARRIRAW T-Link (T-Link kojarzył mi się zawsze z T-Bonem). Jak się zmienił na obecnych Aleksach i Amirach?

Współczesny język marketingowy coraz bardziej działa na nasze zmysły – teraz ARRIRAW jest reklamowany jako przenoszący organiczny look kamery. Na stronie ARRI możemy przeczytać, że jest też „nieskompresowany, niezakodowany i bezkompromisowy”. Ale nie można powiedzieć, że nieprzetworzony.

Odczyt z przetwornika ALEV III odbywa się przez 2 ścieżki 14-bitowych konwerterów analogowo-cyfrowych, przetwarzany w jeden 16-bitowy sygnał. Ma to zapewnić większą rozpiętość tonalną kamery. To ciekawe rozwiązanie w porównaniu z kamerami wykorzystującymi Dual ISO. Tutaj sygnał z 2 ścieżek jest uśredniony, żeby zapewnić większy zapas informacji w czerniach i bielach. (W przypadku kamer z podwójną natywną czułością każda ścieżka była zapisywana jako oddzielny tryb). Sygnał liniowy 16-bitowy jest następnie zapisywany logarytmicznie w formacie ARRIRAW. To rozwiązanie pozwala zmieścić dużą ilość informacji liniowych poprzez zapis logarytmiczny.

Przez lata ARRIRAW przeszedł wiele kosmetycznych zmian, w kolejnych wersjach poprawiono m.in. jakość debayeringu. Nie zmieniła się jednak wielkość zapisu. Jest to mimo upływu lat najbardziej niewydajny pojemnościowo format RAW, ponieważ wraz z wprowadzaniem coraz większych formatów kamer (Alexa 65, Alexa LF) proporcjonalnie zwiększa ilość generowanych danych. Co prawda cena dysków spada, a ich pojemność rośnie, ale nie tak szybko jak ilość danych generowanych przez Aleksę 65. Np. w Studiu Marvel ilość danych powstających przy jednej produkcji jest liczona w setkach terabajtów! Żeby to zarchiwizować na taśmach LTO, producent musi stawiać szafy do magazynowania nośników. A dokoła powstają coraz bardziej wydajne kodeki. Skompresowany RAW zaczął poważnie deptać po piętach ARRI i firma z Niemiec musiała poprosić o pomoc partnera zajmującego się zapisem danych na ich kamerach – firmę Codex Digital. Zanim do tego przejdziemy, zobaczmy, co przygotowali kucharze z Kalifornii.

Medium – REDCODE RAW

Tak jak Stany Zjednoczone Ameryki słyną z hamburgerów i steków, tak kalifornijski RED jest władcą absolutnym zapisu skompresowanego RAW-a. Władcą bardzo sprytnym i zaborczym, bo gdy mało kto interesował się stworzeniem kamery 4K zapisującej surowy obraz z matrycy, RED w 2007 roku skutecznie opatentował zapis „wizualnie bezstratnego, skompresowanego RAW-a”, wykorzystując otwarte formaty, ale spinając je paroma patentami. I jak dotąd nie znalazł się nikt, kto by podważył ten zapis patentowy. RED wygrywał sprawy (albo kończył ugodą) z największymi korporacjami na rynku (m.in. Sony w 2013 roku i Apple pod koniec 2019). Jeżeli ktoś zamierza wykorzystać „skompresowany zapis RAW” w swojej kamerze, prawdopodobnie będzie musiał najpierw zapłacić tantiemy za użycie patentu RED-a. Albo spotkać się z nimi w sądzie.

W naszym menu RED dostał pozycję medium, bo podobnie jak ten rodzaj wysmażenia steków jest najpopularniejszy na świecie. REDcode jest prawdopodobnie najczęściej używanym formatem RAW. Dostępny jest we wszystkich modelach kamer, poczynając od RED One, przez Scarlet I Epic po Monstro i Panavision DXL2. Znajduje się więc w produktach dla odbiorców z rynku półprofesjonalnego po najbardziej wysokobudżetowe produkcje, jak choćby netfliksowy „Wiedźmin”.

Redcode pojawił się razem z kamerą RED One. Od początku był to format RAW używający tak zwanej kompresji stratnej o proporcjach 8:1 i 12:1. Ale jak podkreślali twórcy, był to poziom kompresji „wizualnie bezstratny” i „bardzo sprytny”. W pierwszej wersji, podobnie jak ARRIRAW, zamieniał 16-bitowy odczyt z matrycy na 12-bitowy zapis. Z tą różnicą, że tutaj zawsze był to zapis liniowy. Wraz z pojawieniem się kamery EPIC zapis Redcode (R3D) został zamieniony na 16-bitowy, a kompresję można skalować w zakresie od 3:1 do 22:1.

Jak utrzymują twórcy kodeka, w najniższych proporcjach 2:1 jest format „matematycznie” bezstratny, przy wartościach od 5:1 do 8:1 jest już „wizualnie bezstratny”, a powyżej tego jest to już bardziej subiektywna ocena. I jak podkreślają, im wyższa rozdzielczość, tym poziom kompresji jest mniej zauważalny. Dzięki różnym poziomom kompresji, REDCODE można zapisywać na dużo mniejszych ilościach dysków, przez co czyni workflow RAW bardziej dostępny. Jest to jego bardzo duża zaleta, ale dla zarazem niektórych wada.

Bo REDcode to format skompresowany. I to dosyć mocno. Żeby te pliki otworzyć, potrzeba było zawsze dużych mocy obliczeniowych procesora. A gdy to nie wystarczało, postprodukcje (oraz DIT!) musieli szukać wsparcia w koszmarnie drogich kartach Red Rocket-X. Był to spory problem, ponieważ kodek, który wydawał się objętościowo bardzo przystępny, odbijał się na kosztach maszyn w domach postprodukcyjnych. Na szczęście dzisiaj można powiedzieć, że ten problem nie jest już tak dokuczliwy. RED podpisał umowę o współpracy z firmą produkującą karty graficzne nVidia i teraz stosując sprzęt dla graczy w przystępnych cenach (np. nVidia 2080 Ti RTX), można bez problemu odtwarzać pliki RAW w rozdzielczości 8K w pełnej jakości debayeringu.

Firma RED ma zarówno wielu zwolenników, jak i przeciwników. Ale trzeba jej przyznać, że mimo zaborczej i często kontrowersyjnej strategii strzeżenia swoich patentów, rozpowszechniła workflow oparty na RAW-ach w kinematografii cyfrowej, jak nie zrobił tego żaden inny producent kamer. Jeszcze do niedawna duża część produkcji kręconych na Aleksach, z wyjątkiem naszego filmowego El Dorado, ze względu na koszty była kręcona tylko w plikach Prores.

Well done! – X-OCN od Sony

Mimo że steki well done nie są zamawiane zbyt często przez koneserów dobrej wołowiny, to kodek Sony zasługuje w pełni na tę pozycję w menu z innego powodu: jest po prostu dobrze zrobiony.

X-OCN jest nową odsłoną RAW-a od Sony, nieróżniącą się od poprzednika (Sony RAW SQ) wizualnie. Ale dlaczego nie nazywa się już RAW? Poprzednia wersja już na starcie została zaskarżona do urzędu patentowego przez RED-a. I japoński gigant sprawę przegrał. Prawdopodobnie dlatego Sony omija teraz szerokim łukiem nazwę RAW, a już na pewno nie próbuje połączyć jej ze słowem „skompresowany”, czy „bezstratny”. Japończycy sięgnęli do alternatywnego nazewnictwa, czyli cyfrowego negatywu. I tak został wypromowany eXtended tonal range Original Camera Negative, w skrócie X-OCN. O ile nazwa broni się przed urzędem patentowym, to już nie wpada tak łatwo w ucho jak RAW.

X-OCN ma wszystkie zalety, które znamy z surowych formatów. Mamy dostęp do różnych trybów debayeringu, zmiany wartości ekspozycji, balansu bieli itd. A w trybie ACES podobnie jak przy RED-zie mamy dostęp do 16 bitowych liniowych informacji z sensora. Z jedną bardzo istotną różnicą. X-OCN nie wymaga tak dużych mocy obliczeniowych jak REDCODE. Na komputerze, który nie poradziłby sobie z odtwarzaniem plików w 6K z ALEKSY 65 czy Dragona 6K (6-rdzeniowy MacPro z dwiema kartami Radeon D700), możemy bez problemu obrabiać pliki w tej samej rozdzielczości z Sony Venice. Dodatkowym atutem jest zachowanie dużo mniejszej wielkości plików. Jak podaje Sony, pliki X-OCN ST (Standard) są o 30% mniejsze niż RAW SQ, a różnica w kompresji jest niezauważalna. Doceni to każdy DIT, bo wraca do domu dużo wcześniej po skończeniu zdjęć. A także studio postprodukcyjne, bo nie musi rezerwować dużej ilości miejsca na macierzach na czas postprodukcji. No a w końcu producent, który archiwizuje projekt. To już nie szafa dysków albo taśm LTO, tylko pół szafy.

RAW dla każdego – BRAW

Gdy szykowałem się do zamknięcia menu i wybrania ulubionego steka, na parkingu Steakhouse’u zatrzymał się FoodTruck BlackMagic. I zanim szef kuchni w fartuchu RED-a zdążył go przegonić, część gości zamknęła karty i wybiegła na ulicę.

Kamery firmy BlackMagic, mimo nie najlepszej opinii, bez problemu znajdują zwolenników, dzięki niskiej cenie (za cenę jednej karty 1TB Codexa do ALEKSY można kupić kamerę 6K z sensorem Super 35 zapisującą RAW). Poza tym mają pełne wsparcie najbardziej popularnego (i najtańszego) systemu do korekcji tej samej firmy. Wszystko to działa na korzyść nowości wprowadzanych w linii tych kamer. Nie inaczej jest z nowym kodekiem do zapisu surowych plików z kamer BlackMagic. BRAW zastąpił wcześniej używany w nich otwarty format Cinema DNG. Tym razem BlackMagic opracował własne rozwiązania zapisu, niespotykane u innych producentów. Część debayeringu przy zapisie BRAW odbywa się przed zapisaniem pliku. Dzięki temu do obróbki nie są potrzebne tak duże moce obliczeniowe, co ma znaczenie dla głównych odbiorców kamer BM, czyli niezależnych filmowców i twórców mających mniejsze budżety na zdjęcia i postprodukcję. Poza tym, żeby zmniejszyć objętość plików, można skorzystać z paru trybów kompresji. Podzielono je na mające stałą przepustowość (podobnie jak RED), czyli 3:1, 5:1, 8:1 I 12:1 oraz na zmiennoprzepustowe Q0 i Q5. Ta druga opcja ma dać stałą jakość nie ograniczoną górną granicą zapisu danych. Zapis Blackmagic RAW-ów jest też trochę inaczej przygotowany. Nie mamy do dyspozycji 16-bitowych plików zapisanych liniowo, a 12-bitowe zapisane w niekonwencjonalny nieliniowy sposób. Może właśnie dzięki temu rozwiązaniu, możliwe jest odzyskanie około jednej przysłony w światłach, po zaznaczeniu opcji „Highlight Recovery” w DaVinci Resolve.

Dekodowanie w komputerze jest podzielone pomiędzy procesor i karty graficzne. Blackmagic współpracuje z każdym systemem zastosowanym w kartach graficznych, więc można wykorzystać najpopularniejsze standardy CUDA, Open CL czy Metal.

Codex HDE, czyli skompresowany ARRIRAW

Zamieszanie na parkingu przed restauracją zaczęło robić się coraz większe, gdy sprzedawca jabłek (Apple) postanowił także spróbować szczęścia w małej gastronomii, rozstawiając swój grill obok FoodTrucka i serwując nowe ProResy RAW. Ale widząc jak czerwony z wściekłości kucharz w fartuchu RED-a wygraża mu pięścią (trzymając w drugiej ręce opinię urzędu patentowego), równie szybko się zwinął.

Po chwili zamieszania goście jednak wrócili do środka, bo okazało się, że niemieccy kucharze mieli dla nich niespodziankę. Skompresowany ARRIRAW, osobiście przygotowany przez firmę Codex Digital.

Przepraszam, nie „skompresowany”, a „zakodowany”. Widać, że słowo kompresja budzi złe skojarzenia, a także strach przed urzędem patentowym. Pełna nazwa nowego trybu zapisu to Codex High Density Encoding, w skrócie HDE. Jest dostępny tylko dla materiałów z kamer ARRI i zmniejsza ich objętość o mniej więcej 40% (kompresja około 2:1). HDE powstał pod naciskiem studiów z Hollywood, ponieważ kamery ARRI generują zbyt duże ilości danych i przy produkcjach wielokamerowych pojawił się problem z ilością materiałów, które trzeba zarchiwizować w paru kopiach (wyobraźmy sobie film na 2 kamery Alexa 65, 50 dni zdjęciowych, zarchiwizowany w minimum 3 kopiach). A jak go włączyć w kamerze czy potrzebny jest update? Skądże. Cały ciężar przekodowania materiałów spada na DIT i jego sprzęt. Kamera dalej rejestruje ARRIRAW normalnie. Kodowanie do HDE odbywa się podczas procesu kopiowania i jest uzależnione od mocy procesora na komputerze przeznaczonym do zgrywania. Nie ma znaczenia podpięty dysk. Jeżeli na macierz zrobioną z dysków SSD albo NVMe kopiowalibyśmy w 15 minut na MacBooku pro 1TB materiałów zapisanych w 4K, to w przypadku HDE „kopia” (z zakodowaniem) wydłuży się dwukrotnie. Żeby przenieść godzinę materiału (2TB) w czasie 2 razy szybszym, potrzeba będzie już 10-rdzeniowego komputera. Przypomnę jeszcze, że odczytywanie plików zapisanych w systemie Codexa jest możliwe tylko na komputerach Mac. Czyli do pracy w pełni wydajnej potrzebny jest przynajmniej iMac Pro albo nowy Mac Pro, zwany tarką do sera. Czyli do zakodowania tych plików potrzeba podobnego sprzętu, jaki jeszcze do niedawna był potrzebny w postprodukcji do odtworzenia materiałów z RED-a w 8K. Z jedną małą różnicą – postprodukcje mogły korzystać z komputerów opartych na systemie Windows i wielokrotnie tańszych komponentów do nich.

Żeby było ciekawiej, do skorzystania z HDE potrzebny jest oryginalny czytnik firmy Codex, który służy jako klucz licencyjny. Zmartwi to szczęśliwych posiadaczy czytników kart Cfast z interfejsem Thunderbolt 2, bo zamiast kopiować dane z pełną prędkością zapisu karty (~500MB/s), będą musieli korzystać z Codexowego, który jest zablokowany mniej więcej w połowie tej przepustowości.

HDE działa jak każdy kodek. Skoro został zakodowany w momencie zapisu, będzie musiał być odkodowany podczas obróbki materiałów. I tak jak przy zapisie, będzie potrzebna spora moc obliczeniowa procesora. Mamy tutaj do wyboru dwie drogi: albo materiały zostaną rozpakowane przed obróbką z plików .arx (bo tak archiwizuje HDE) do plików .ari, albo programy do korekcji czy efektów specjalnych będą pracowały na plikach zakodowanych. Oczywiście wykorzystując bardzo duże zasoby procesora na sam proces odkodowania. Brzmi znajomo? Tak działa od ponad dekady Redcode. Skompresowany RAW.

W ten sposób ARRI wyszło obronną ręką z sytuacji, gdy dokoła pojawiają się nowe skompresowane i równie wydajne formaty, a argument o posiadaniu jedynego „nieskompresowanego, nieprzetworzonego” formatu nie trafia już do producentów. Mało tego, rozwiązanie Codeksa nie jest wprowadzone w kamerze, więc ARRI nie musi bić się już z RED-em o „zapis skompresowanego RAW”.

Co wybrać?

Można się spierać czy T-Bone będzie lepszy od Bistecci Fiorentina, Rib Eye od Porterhouse’a itd. Podobnie jest z RAW-ami z kamer cyfrowych. W większości przypadków to kwestia gustu. I budżetu.

Najważniejszą wspólną zaletą formatów RAW jest możliwość dowolnego ich przetworzenia. A poziom kompresji, jeżeli użyty świadomie, może być głównie zaletą, bo oszczędza magazynowanie materiału. A jeżeli jest wizualnie bezstratny, to tym lepiej, chodzi w końcu o to, co widzimy na ekranie, a nie o skomplikowanie obliczeń matematycznych odbywających się w tle. Podobnie jest z dobrym jedzeniem, warto być świadomym, co ma się na talerzu, słuchając głosu własnego podniebienia.

Smacznego!